Preparación de datos para Machine Learning: Guía completa para un modelo eficiente

La preparación de datos es un paso fundamental en el proceso de Machine Learning. Para obtener un modelo eficiente y preciso, es necesario asegurarse de que los datos estén limpios, organizados y listos para ser utilizados. En esta guía completa, exploraremos las mejores prácticas y técnicas para preparar tus datos de manera efectiva.

1. Análisis y exploración de datos

Antes de comenzar a preparar tus datos, es importante realizar un análisis y exploración exhaustiva de los mismos. Esto implica revisar la estructura de los datos, identificar valores faltantes o nulos, y comprender la distribución de los atributos. También es recomendable realizar gráficos y visualizaciones para obtener una mejor comprensión de los datos.

Además, es importante detectar y eliminar valores atípicos que puedan afectar el rendimiento del modelo. Estos valores pueden distorsionar los resultados y conducir a predicciones incorrectas.

Una vez que tengamos una comprensión clara de los datos, podemos comenzar con la etapa de limpieza y transformación.

2. Limpieza de datos

La limpieza de datos es un paso crucial para garantizar la calidad de los mismos. Aquí, nos enfocamos en eliminar valores duplicados, corregir errores y tratar con valores faltantes o nulos.

Te puede interesar...Algoritmos de Machine Learning que Deberías ConocerPara lidiar con valores nulos, podemos optar por eliminar las filas o columnas que los contienen o llenarlos con valores imputados. La elección depende del contexto y la naturaleza de los datos.

Además, si hay datos categóricos, es posible que sea necesario convertirlos a variables numéricas para que el modelo pueda procesarlos adecuadamente.

3. Codificación de variables categóricas

En muchos conjuntos de datos, es común encontrar variables categóricas que deben ser codificadas adecuadamente para su uso en un modelo de Machine Learning.

Existen diferentes enfoques para la codificación de variables categóricas, como la codificación one-hot o la codificación ordinal. La elección depende de la relación y la naturaleza de las categorías.

La codificación adecuada de variables categóricas es esencial para evitar sesgos y asegurar que el modelo pueda interpretar correctamente las relaciones entre las variables.

Te puede interesar...Machine Learning y Ciberseguridad: Protegiendo Datos Sensibles4. Normalización y estandarización

La normalización y estandarización son técnicas utilizadas para escalar los atributos y garantizar que todos los valores se encuentren en el mismo rango. Esto es especialmente importante cuando se utilizan algoritmos que son sensibles a la escala, como los basados en distancia.

La normalización escala los valores de los atributos a un rango específico, como entre 0 y 1. La estandarización, por otro lado, transforma los valores a una distribución con media cero y desviación estándar uno.

La elección entre normalización y estandarización depende del algoritmo utilizado y la distribución de los datos. En general, es recomendable experimentar con ambas técnicas y evaluar su impacto en el rendimiento del modelo.

5. División en conjuntos de entrenamiento y prueba

Una buena práctica en Machine Learning es dividir los datos en conjuntos de entrenamiento y prueba. El conjunto de entrenamiento se utiliza para entrenar el modelo, mientras que el conjunto de prueba se utiliza para evaluar su rendimiento y generalización.

Es recomendable utilizar una proporción adecuada de los datos para cada conjunto, como el 80% para entrenamiento y el 20% para prueba. Esto asegura que el modelo se entrene con suficientes ejemplos, pero también se evalúe en datos no vistos.

Te puede interesar...Desarrollando Aplicaciones Prácticas con Machine LearningLa división en conjuntos de entrenamiento y prueba también nos permite realizar validación cruzada y ajustar los hiperparámetros del modelo.

6. Conclusiones

La preparación de datos es un paso fundamental en el proceso de Machine Learning. Siguiendo buenas prácticas como el análisis y exploración de datos, la limpieza, codificación, normalización y estandarización, y la división en conjuntos de entrenamiento y prueba, podemos asegurarnos de que nuestros datos estén listos para ser utilizados en un modelo eficiente.

Tomarse el tiempo para preparar adecuadamente los datos puede marcar la diferencia entre un modelo mediocre y uno altamente preciso. Con una preparación adecuada, podemos maximizar el rendimiento del modelo y obtener mejores resultados en nuestras predicciones.

Preguntas frecuentes

1. ¿Qué sucede si no se realiza una limpieza de datos adecuada?

Si no se realiza una limpieza de datos adecuada, es probable que el modelo se vea afectado por valores incorrectos, valores atípicos y valores nulos. Esto puede conducir a predicciones inexactas y un rendimiento deficiente del modelo. La limpieza de datos es esencial para garantizar la calidad y confiabilidad de los resultados del modelo.

2. ¿Cuál es la diferencia entre normalización y estandarización?

La normalización escala los valores de los atributos a un rango específico, como entre 0 y 1. Esto es útil cuando se desea comparar valores en diferentes escalas. La estandarización, por otro lado, transforma los valores a una distribución con media cero y desviación estándar uno. Esto es útil cuando se desea que los datos sigan una distribución normal y cuando se utilizan algoritmos sensibles a la escala.

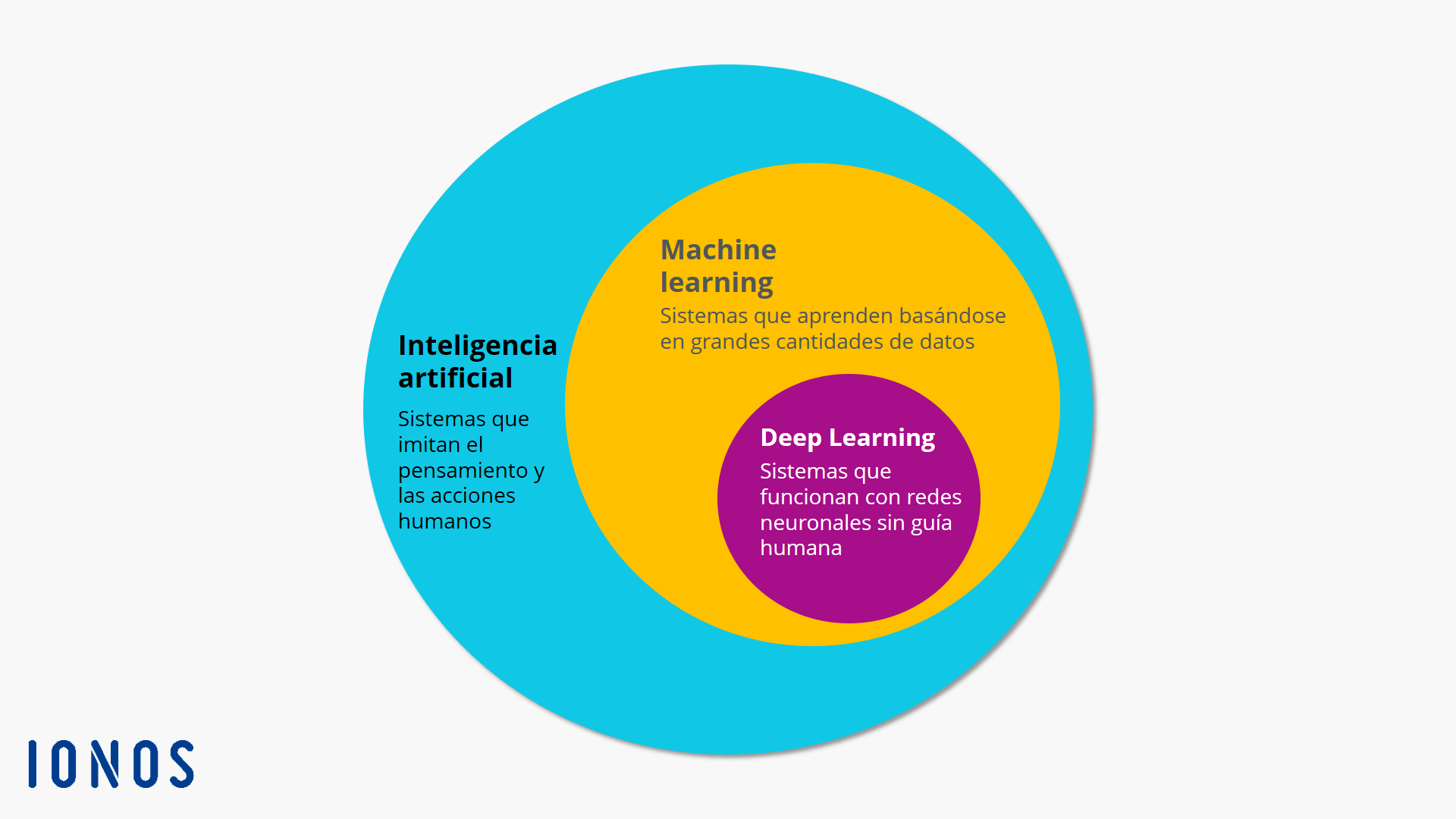

Te puede interesar...Machine Learning vs. Inteligencia Artificial: Diferencias Clave3. ¿Es necesario codificar todas las variables categóricas?

No todas las variables categóricas necesitan ser codificadas. Algunos algoritmos pueden manejar directamente variables categóricas sin codificar, mientras que otros requieren que se realice una codificación adecuada. La elección depende del algoritmo y la relación de las categorías en los datos.

4. ¿Por qué es importante dividir los datos en conjuntos de entrenamiento y prueba?

Dividir los datos en conjuntos de entrenamiento y prueba nos permite evaluar el rendimiento y la generalización del modelo en datos no vistos. Esto ayuda a evitar el sobreajuste y permite la selección adecuada de hiperparámetros. También nos permite tener una medida realista de la precisión del modelo en situaciones del mundo real.